图神经网络能够处理复杂的图结构数据,在芯片设计、能源规划、推荐系统等多个领域具有广泛应用前景。随着数据规模和复杂性的增长,单个计算单元已无法满足大规模图数据的处理需求。尽管使用多GPU加速GNN训练逐渐成为主流,全批次图神经网络的分布式训练仍面临严重负载不平衡和高通信开销等挑战。

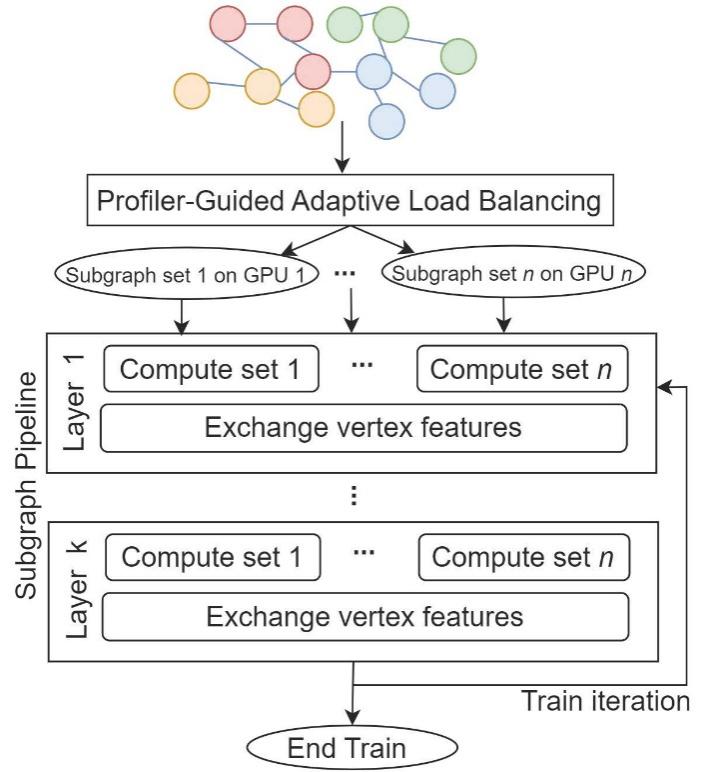

我中心人工智能技术与应用发展部门设计了高效全批次训练系统ParGNN。该系统采用了一种由负载均衡器指导的自适应负载均衡方法,并结合图过划分策略有效缓解了计算负载不平衡的问题。ParGNN实现了新型子图流水线算法,使得计算和通信过程得以重叠,从而在不影响GNN训练精度的前提下大幅提高了效率。实验表明,相较于当前最先进的解决方案DGL和Pipe GCN,ParGNN不仅能实现最高的训练精度,还能在最短时间内达到预设目标精度。此项研究成果已被第62届国际设计自动化会议Design Automation Conference(DAC 2025,CCF推荐A类会议)录用。该成果得到国家重点研发计划(2023YFB4502303)和中国科学院先导专项(XDB0500103)的支持。

ParGNN总体设计

论文第一作者为我中心博士研究生顾峻瑜,我中心副研究员曹荣强和博士研究生李顺德为共同一作,通信作者为我中心王珏正高级工程师。

相关成果

Junyu Gu,Shunde Li,Rongqiang Cao,Jue Wang,Zijian Wang,Zhiqiang Liang,Fang Liu,Shigang Li,Chunbao Zhou,Yangang Wang,Xuebin Chi. ParGNN: A Scalable Graph Neural Network Training Framework on multi-GPUs. Proceedings of the 62st ACM/IEEE Design Automation Conference. 2025.

责任编辑:郎杨琴