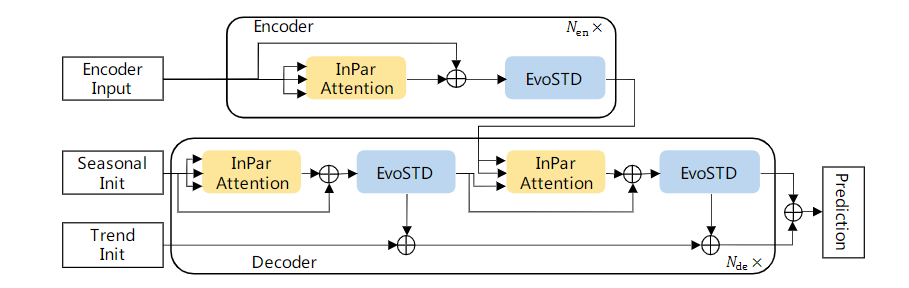

我中心基于Transformer模型提出了一种新型时序预测模型InParformer,其主要由交互式并行注意力机制和进化分解模块组成,在多个真实世界时序公开数据集的预测性能优于现有基于Transformer的长时序预测模型。相应的模型库已经部署在中心的人工智能数据与计算应用服务平台(平台链接:http://data.aicnic.cn/)。

图 1 InParformer框架

该研究成果已被人工智能领域的国际顶级会议AAAI (CCF A类)2023接收。论文第一作者为人工智能部2020级的硕士研究生操海洲,导师王珏正高级工程师为通信作者。

在“碳中和、碳达峰”背景下,我中心提出了基于时间相关性注意力机制和领域知识的时序预测模型,并在新能源领域真实世界光伏出力数据集上获得了良好的预测效果。该研究成果已在国际知名会议KSEM(International conference on Knowledge Science, Engineering and Management,CCF C类)2022发表。2020级博士研究生姚铁锤在导师迟学斌研究员、王彦棡研究员和王珏正高级工程师的指导下参加了KSEM 2022会议并作线上报告,荣获KSEM 2022最佳学生论文奖(Best Student Paper Award。此次KSEM 2022共收到投稿498篇论文,最终评出3篇最佳学生论文。

图 2 KSEM 2022最佳学生论文奖

该成果得到科技创新2030 “新一代人工智能”重大项目“全面支持国家AI标准体系的深度学习开源框架”和中科院战略先导(A)子课题“自主进化计算开放平台”的支持。

相关成果:

[1] Cao, Haizhou, Zhenhao Huang, Tiechui Yao, Jue Wang*, Hui He, and Yangang Wang. "InParformer: Evolutionary Decomposition Transformers with Interactive Parallel Attention for Long-Term Time Series Forecasting." In Proceedings of the AAAI Conference on Artificial Intelligence. 2023. (accepted)

[2] Yao, Tiechui, Jue Wang*, Haizhou Cao, Fang Liu, Xiaoguang Wang, Yangang Wang, and Xuebin Chi. "A Multi-level Attention-Based LSTM Network for Ultra-short-term Solar Power Forecast Using Meteorological Knowledge." In International Conference on Knowledge Science, Engineering and Management, pp. 16-28. Springer, Cham, 2022.